在过去的几年中,自然语言处理(NLP)领域取得了重大进展,诸如BERT,ALBERT,ELECTRA和XLNet之类的模型在各种任务中均取得了惊人的准确性。在预训练期间,矢量表示是基于大量文本语料(例如Wikipedia)形成的,这些文本语是通过掩盖单词并尝试对其进行预测而获得的(所谓的“掩盖语言建模”)。结果表示会编码有关语言以及概念之间(例如,外科医生和手术刀之间的)关系的大量信息。然后训练的第二阶段-微调-在模型中,模型使用针对特定任务的数据进行了锐化处理,以学习如何使用通用的预训练表示法执行特定任务,例如分类。考虑到此类模型在各种NLP问题中的广泛使用,至关重要的是了解它们包含的信息以及任何学习的关系如何影响模型在其应用中的结果,以确保它们符合人工智能原理(AI)。

文章“在预训练的NLP模型中测量性别相关性”探讨了BERT模型及其轻巧的表亲ALBERT,以寻找与性别相关的关系,并提出了一些使用预训练的语言模型的最佳实践。作者以公共模型权重和探索性数据集的形式展示了实验结果,以证明最佳实践的应用,并为进一步研究参数提供了基础,这超出了本文的范围。此外,作者计划布置一组权重Zari,以减少性别相关性的数量,但在标准NLP问题上仍保持高质量。

测量相关性

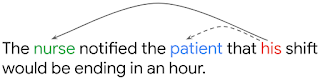

为了理解预训练视图中的相关性如何影响应用问题中的指标,作者应用了多种评分指标来研究性别表征。这些测试之一是基于解决共指问题的,该问题的意义在于模型能够理解句子中代词的先行词。例如,在下面的句子中,模型必须识别出他指的是护士(在这种情况下是护士),而不是患者。

– OntoNotes (Hovy et al., 2006). F1-, ( Tenney et al. 2019). OntoNotes , WinoGender, , , . ( 1) WinoGender , (.. nurse , ). , , , - , .

BERT ALBERT OntoNotes () WinoGender ( ). WinoGender , , .

, (Large) BERT, ALBERT WinoGender, ( 100%) (accuracy) OntoNotes. , . : , . , .. , , , , .

: NLP- ?

- : , , , . , BERT ALBERT 1% , 26% . : , WinoGender , , , , , , (male nurse).

- : , . , , , , . , , - (dropout regularization), : (dropout rate) BERT ALBERT, . , , , .

- : : , , WinoGender - . , OntoNotes ( BERT'), , - , . (. ).

, NLP-, . , . , , , , . , , , .

- — Kellie Webster

- 翻译-叶卡捷琳娜·斯米尔诺娃

- 编辑和排版-谢尔盖Shkarin