我们的世界正在产生越来越多的信息。它的某些部分会暂时消失,并在收集后立即丢失。另一个应存放更长的时间,而另一个则应设计“数百年”-至少这是我们从现在开始所看到的。信息流以如此快的速度在数据中心中沉降,以至于任何新方法,旨在满足这一无穷“需求”的任何技术都将很快过时。

分布式存储系统发展40年

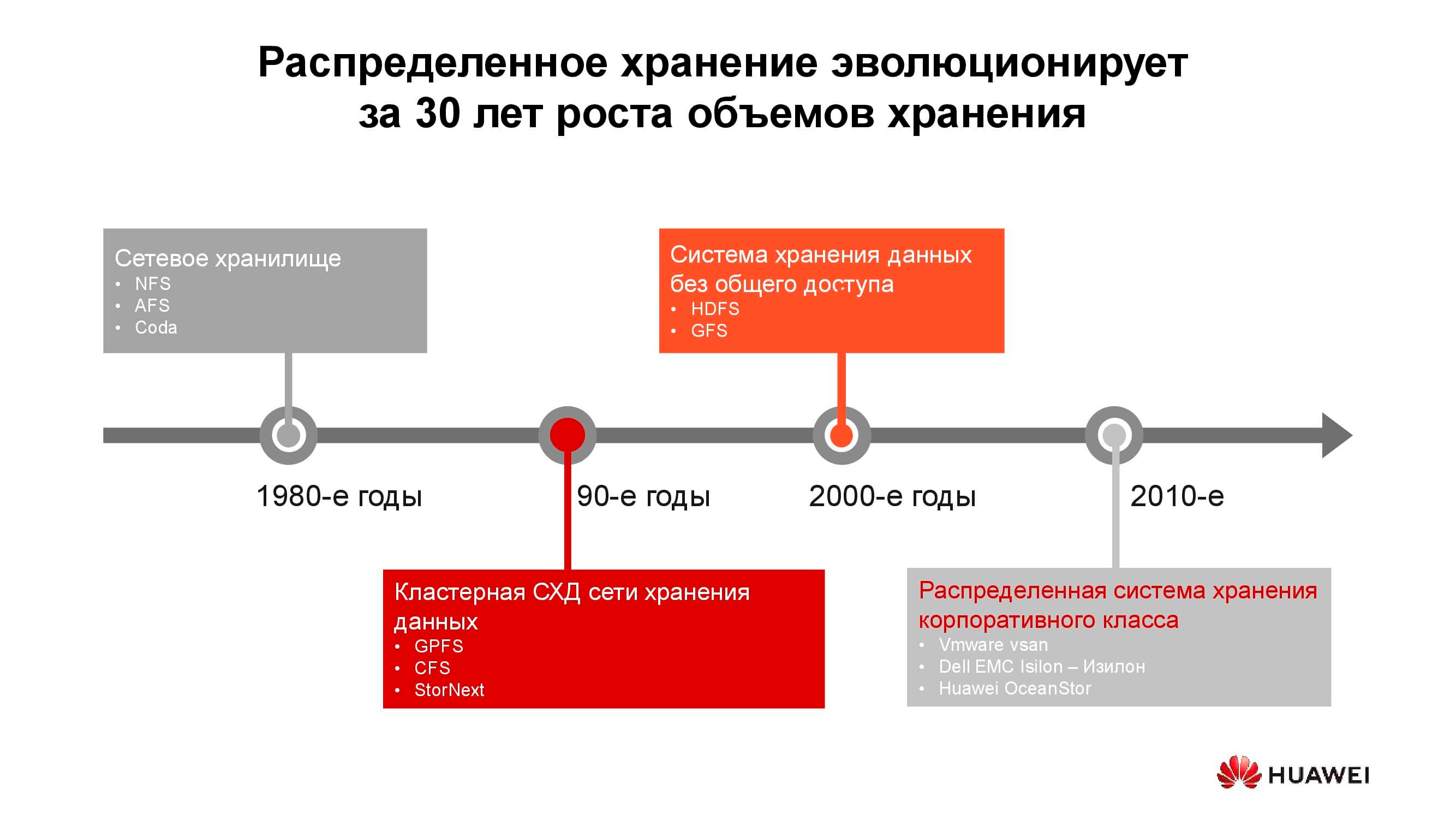

第一个网络连接的存储设备以常规形式出现在1980年代。你们中的许多人都遇到过NFS(网络文件系统),AFS(Andrew文件系统)或Coda。十年后,时尚和技术发生了变化,分布式文件系统被基于GPFS(通用并行文件系统),CFS(集群文件系统)和StorNext的集群存储系统所取代。作为基础,使用了经典体系结构的块存储,并在其之上使用软件层创建了单个文件系统。这些和类似的解决方案仍在使用中,占据着自己的利基市场,并且需求很大。

在世纪之交,分布式存储的范例已经发生了一些变化,并且采用SN(无共享)架构的系统处于领先地位。从群集存储到单独节点上的存储都有过渡,通常这是具有可提供可靠存储的软件的经典服务器。可以基于HDFS(Hadoop分布式文件系统)和GFS(全局文件系统)构建此类原则。

接近2010年代,分布式存储的基本概念越来越多地反映在成熟的商业产品中,例如VMware vSAN,Dell EMC Isilon和我们的华为OceanStor。... 提到的平台后面不再是爱好者社区,而是负责产品功能,支持,服务并保证其进一步开发的特定供应商。在几个领域中最需要这种解决方案。

电信运营商

分布式存储系统最古老的消费者之一可能是电信运营商。该图显示了哪些应用程序组产生大量数据。 OSS(运营支持系统),MSS(管理支持服务)和BSS(业务支持系统)是向订户提供服务,向提供商提供财务报告以及为运营商工程师提供运营支持所需的三个互补软件层。

通常,这些层的数据彼此强烈混合,并且为了避免不必要副本的积累,使用了分布式存储,这些存储存储了来自工作网络的全部信息。存储组合到一个公共池中,所有服务都引用该公共池。

我们的计算表明,从传统存储系统到块存储系统的过渡仅由于放弃了专用高端存储系统并使用经典体系结构的常规服务器(通常为x86),再加上专门的软件,您最多可以节省70%的预算。蜂窝运营商很早就开始大量购买此类解决方案。尤其是,俄罗斯运营商使用华为的此类产品已有六年多了。

是的,使用分布式系统无法执行许多任务。例如,对性能的要求提高或与较旧的协议兼容。但是,操作员处理的至少70%的数据可以位于分布式池中。

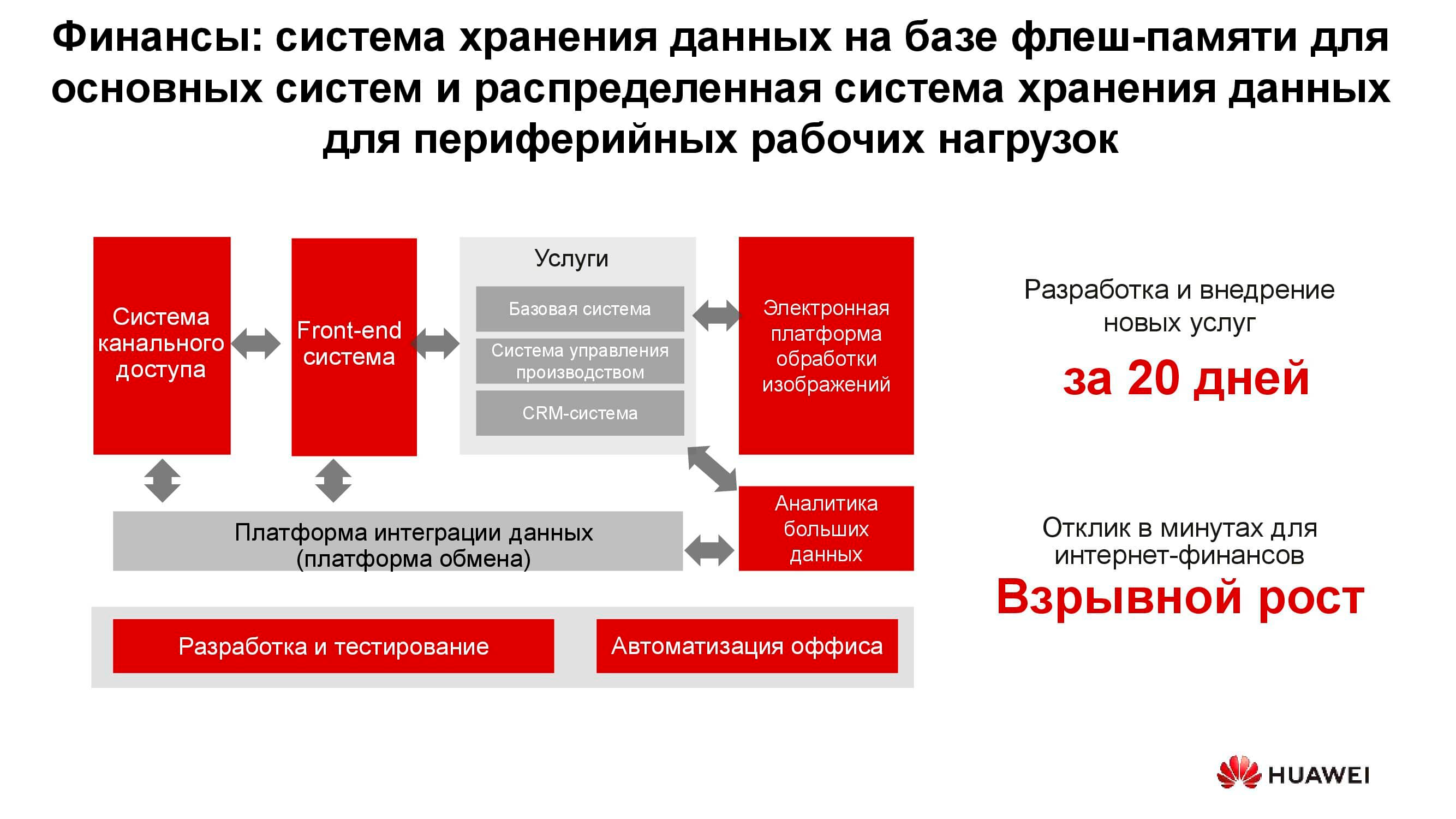

银行业

在任何一家银行中,从处理到自动银行系统,都有许多不同的IT系统并排。该基础架构还可以处理大量信息,而大多数任务不需要提高存储系统的性能和可靠性,例如开发,测试,办公流程的自动化等。在这里,可以使用经典存储系统,但每年的利润越来越少。另外,在这种情况下,存储资源的使用没有灵活性,存储资源的性能是根据峰值负载来计算的。

使用分布式存储系统时,它们的节点(实际上是普通服务器)可以随时转换为例如服务器场并用作计算平台。

数据湖

上图显示了数据湖服务的典型使用者列表。这些可以是电子政务服务(例如“ Gosuslugi”),数字化企业,财务结构等。它们都需要处理大量的异构信息。

传统存储系统解决此类问题的操作是无效的,因为需要对块数据库的高性能访问和对作为对象存储的扫描文档库的常规访问。也可以通过Web门户链接到例如订购系统。要在经典存储平台上实现所有这些功能,您将需要大量设备来完成不同的任务。一个水平的通用存储系统可以很好地覆盖之前列出的所有任务:您只需要在其中创建几个具有不同存储特性的池即可。

新信息的产生者

世界上存储的信息量每年以大约30%的速度增长。对于存储供应商来说,这是个好消息,但是这些数据的主要来源是什么?

十年前,社交网络成为这种生成器,需要创建大量新算法,硬件解决方案等。现在,存储量增长的三个主要驱动力。首先是云计算。当前,大约70%的公司以一种或另一种方式使用云服务。这些可以是电子邮件系统,备份和其他虚拟化实体。

第二个驱动程序是第五代网络。这些是新的速度和新的数据传输量。我们预计5G的广泛采用将导致对闪存卡的需求下降。无论手机中有多少内存,它仍然会用完,并且如果小工具中有100兆通道,则无需在本地存储照片。

对存储系统需求增长的第三组原因包括人工智能的快速发展,向大数据分析的过渡以及一切可能实现通用自动化的趋势。

“新流量”的独特之处在于它的结构化... 我们需要存储此数据而不指定其格式。仅在以后阅读时才需要。例如,一个确定可用贷款金额的银行评分系统将查看您在社交网络上发布的照片,确定您是否经常去海边和在餐馆里用餐,同时研究可用于其医疗文件的摘录。这些数据一方面是无所不包的,另一方面却缺乏统一性。

非结构化数据的海洋

“新数据”的出现会带来什么问题?当然,其中最重要的是信息本身的数量和估计的存储时间。一辆不带驾驶员的现代自动驾驶汽车每天从其所有传感器和机械装置产生多达60 TB的数据。要开发新的运动算法,必须在同一天处理此信息,否则它将开始累积。而且,它应该保存很长的时间-几十年。只有这样,将来才有可能基于大量的分析样本得出结论。

一种基因测序设备每天可产生约6 TB的数据。并且在其帮助下收集的数据根本不意味着删除,也就是说,假设应永久存储。

最后,所有相同的第五代网络。除了实际传输的信息之外,这样的网络本身还是巨大的数据生成器:操作日志,呼叫记录,机器对机器交互的中间结果等。

所有这些都需要开发用于存储和处理信息的新方法和算法。这样的方法出现了。

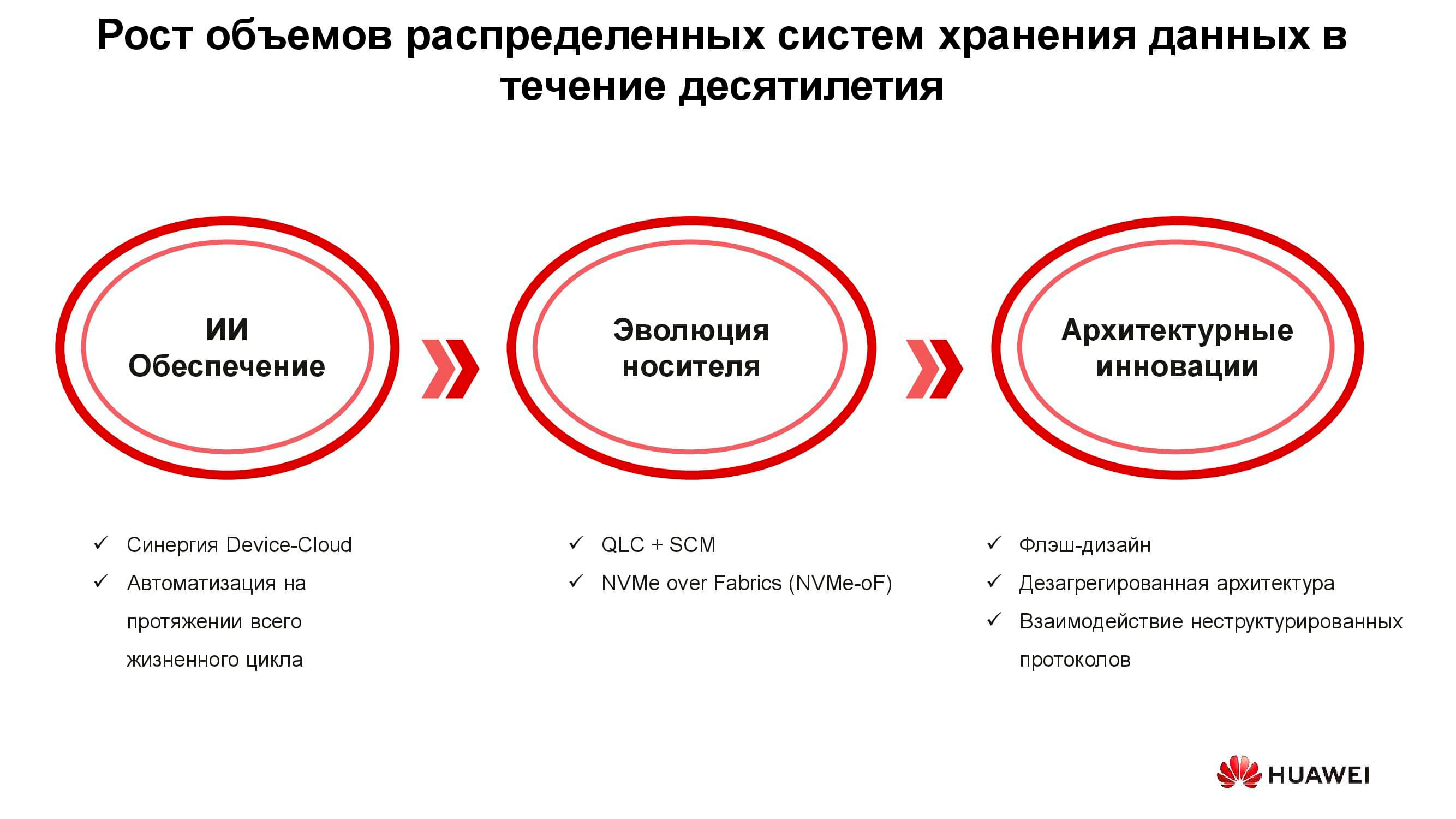

新时代的技术

设计了三组解决方案来应对存储系统的新要求:人工智能的引入,存储介质的技术发展以及系统架构领域的创新。让我们从AI开始。

在新的华为解决方案中,人工智能已经在存储本身的层面上使用,该人工智能配备了AI处理器,可以使系统独立分析其状态并预测故障。如果存储系统连接到具有强大计算能力的服务云,那么人工智能可以处理更多信息并提高其假设的准确性。

除了故障之外,这种AI还能预测未来的峰值负载以及容量耗尽之前的剩余时间。这样,即使在发生任何不需要的事件之前,您也可以优化性能并扩展系统。

现在介绍数据载体的发展。首批闪存驱动器是使用SLC(单级单元)技术制成的。基于它的设备快速,可靠,稳定,但容量小且非常昂贵。数量的增加和价格的降低是通过某些技术让步实现的,因此降低了驱动器的速度,可靠性和使用寿命。但是,这种趋势并没有影响存储系统本身,由于各种体系结构的调整,存储系统本身通常变得更加高效和可靠。

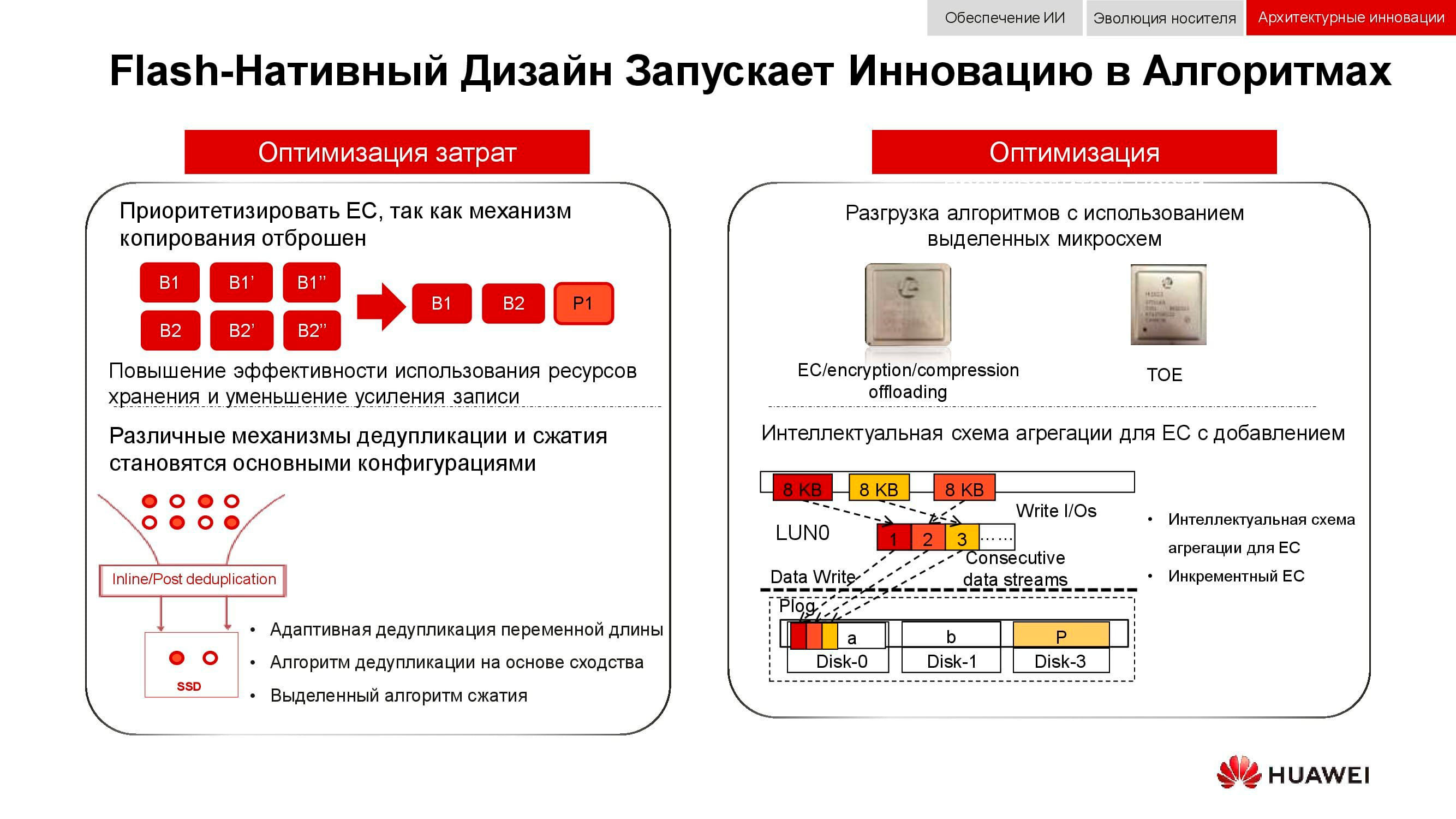

但是,为什么需要全闪存存储系统?用相同尺寸的新SSD替换已经使用的系统中的旧HDD还不够吗?这样做是为了有效地使用新固态驱动器的所有资源,而这在旧系统中根本是不可能的。

例如,华为已经开发了一系列技术来应对这一挑战,其中之一就是FlashLink,它可以最大限度地提高磁盘与控制器之间的交互。

通过智能识别,可以将数据分解为多个流,并应对许多不良现象,例如WA(写放大)。同时,新的恢复算法,尤其是RAID 2.0+,提高了重建速度,将其时间缩短到完全微不足道的时间。

故障,拥挤,垃圾回收-由于控制器的特殊修改,这些因素也不再影响存储系统的性能。

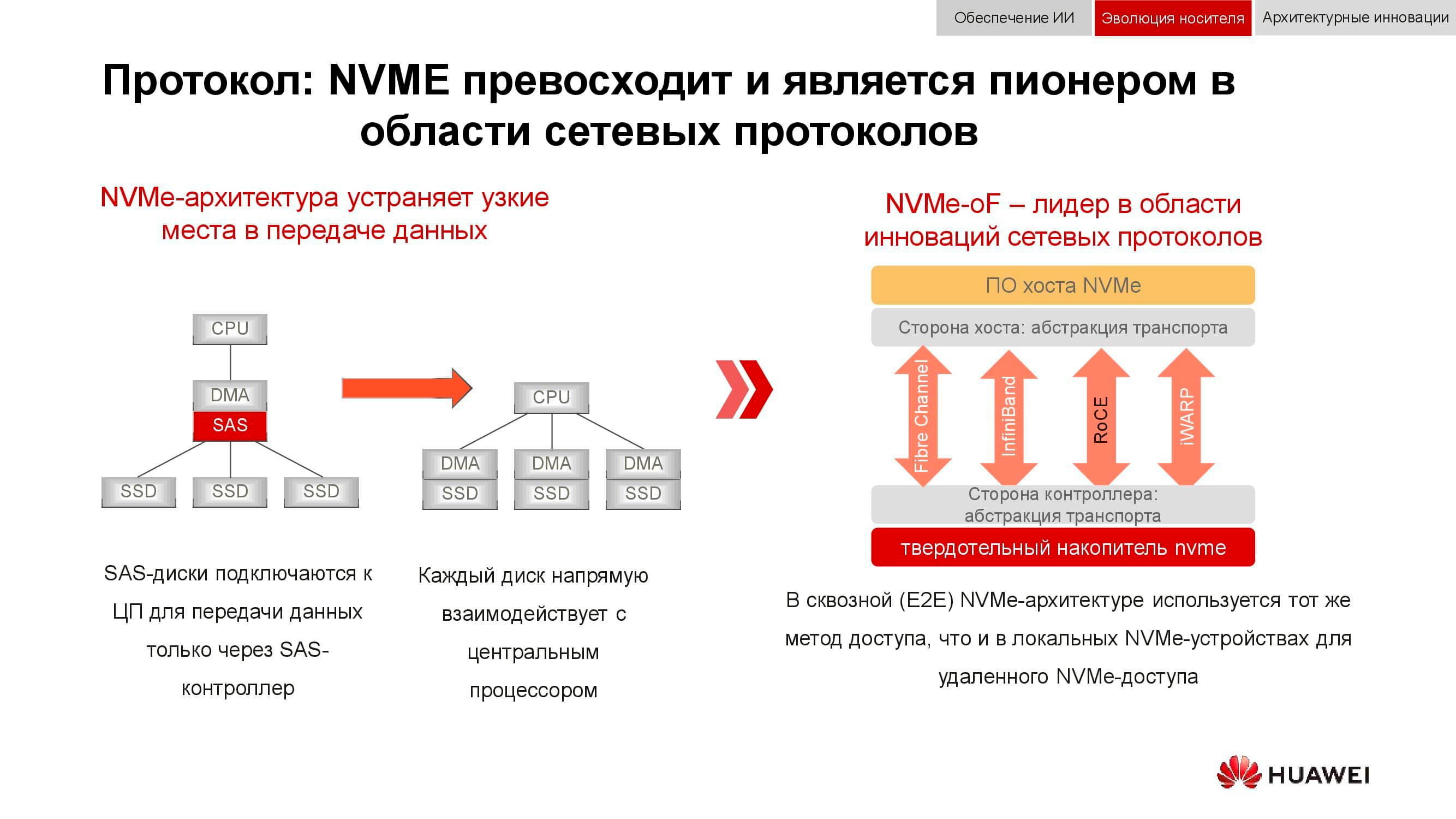

并且块数据存储已为NVMe准备就绪。回想一下,组织数据访问的经典方案的工作方式如下:处理器通过PCI Express总线访问RAID控制器。进而通过SCSI或SAS与机械磁盘进行交互。在后端使用NVMe大大加快了整个过程,但是它有一个缺点:驱动器必须直接连接到处理器,以便提供对内存的直接访问。

我们现在看到的技术开发的下一阶段是使用NVMe-oF(基于织物的NVMe)。至于华为模块技术,它们已经支持FC-NVMe(光纤通道上的NVMe)和基于RoCE的NVMe(聚合以太网上的RDMA)方法。测试模型非常实用,还需要几个月的时间才能正式发布。请注意,所有这一切还将出现在对“无损以太网”的需求量很大的分布式系统中。

优化分布式存储工作的另一种方法是完全拒绝数据镜像。华为解决方案不再像通常的RAID 1中那样使用n个副本,而是完全切换到EC机制(擦除编码)。具有特定频率的特殊数学程序包可计算控制块,使您可以在丢失数据的情况下恢复中间数据。

重复数据删除和压缩机制正变得必不可少。如果在经典存储系统中,我们受到安装在控制器中的处理器数量的限制,那么在分布式横向扩展存储系统中,每个节点都包含您所需的一切:磁盘,内存,处理器和互连。这些资源足以使重复数据删除和压缩对性能的影响降到最低。

以及关于硬件优化的方法。在这里,有可能减少对中央处理器的负载与额外的专用集成电路(或专用模块在处理器本身),其作用的发挥帮助TOE(TCP / IP卸载引擎)或接管EC,重复数据删除和压缩的数学问题。

数据存储的新方法体现在分布式(分布式)架构中。在集中式存储系统中,有一个服务器工厂,通过光纤通道连接到具有大量阵列的SAN。这种方法的缺点是难以扩展和提供有保证的服务级别(性能或延迟)。超融合系统使用相同的主机来存储和处理信息。这实际上提供了无限的可扩展性,但是维护数据完整性需要付出高昂的成本。

与上述两者相反,分解式架构意味着将系统分为计算架构和水平存储系统。这提供了两种体系结构的优势,并允许您无限期地仅扩展到缺乏性能的元素。

从整合到融合

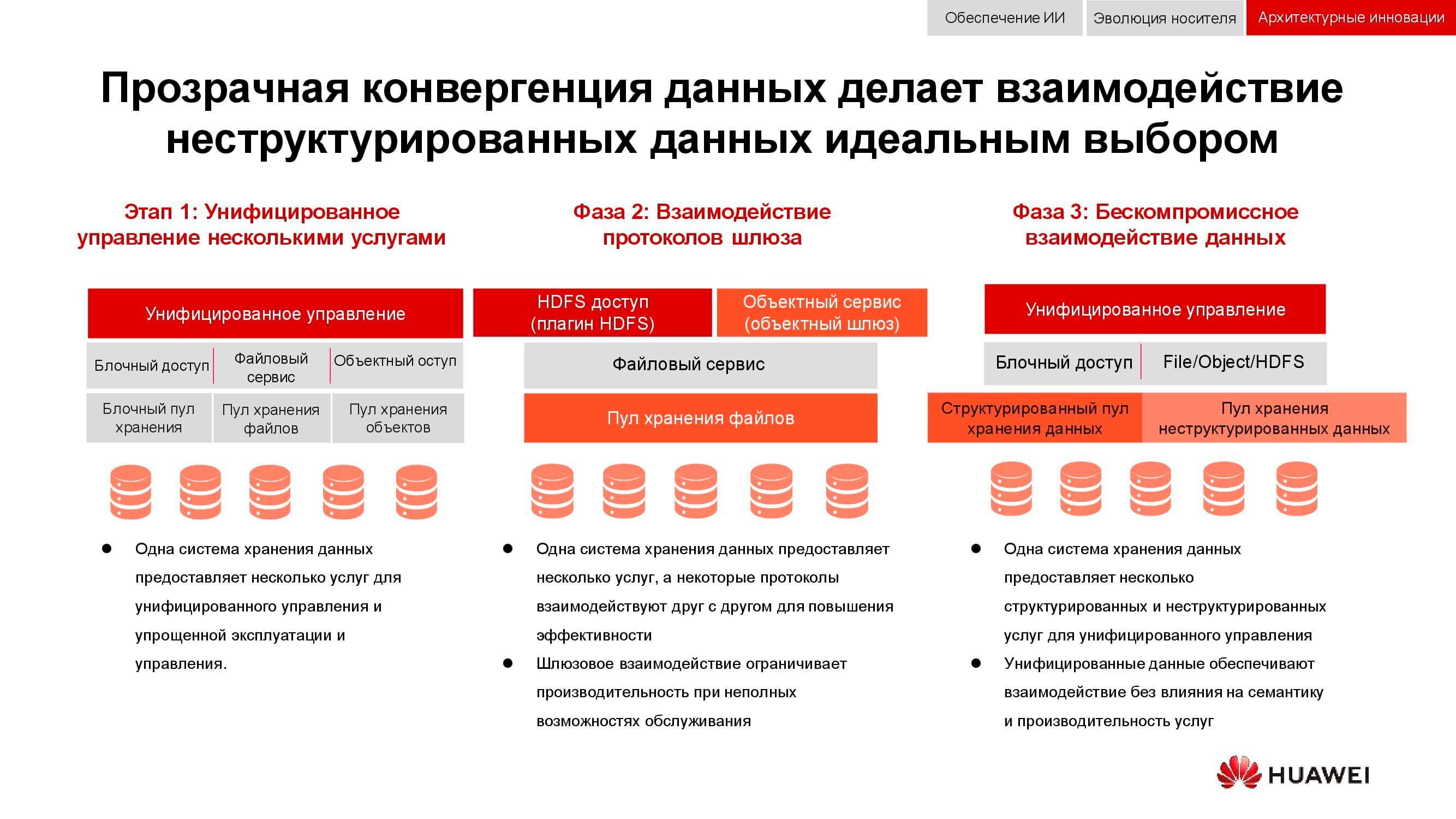

相关性仅在过去15年中才增长的一项经典任务是需要同时提供块存储,文件访问,对对象的访问,大数据的场操作等。蛋糕上的樱桃也可以是例如磁带的备份系统。

在第一阶段,只有这些服务的管理是统一的。异构数据存储系统被锁定在某些专用软件中,管理员可以通过该软件从可用池中分配资源。但是,由于这些池的硬件不同,因此不可能在它们之间迁移负载。在更高的集成级别,合并是在网关级别进行的。如果存在共享文件访问,则可以通过不同的协议来提供它。

现在,我们可以使用的最先进的收敛方法涉及创建通用混合系统。正是我们的OceanStor 100D应该是。可访问性使用相同的硬件资源,在逻辑上划分为不同的池,但允许进行工作负载迁移。所有这些都可以通过一个管理控制台完成。这样,我们设法实现了“一个数据中心-一个存储系统”的概念。

现在,存储信息的成本决定了许多架构决策。尽管可以放心地将其放在首位,但今天我们正在讨论具有主动访问权限的实时存储,因此也必须考虑性能。下一代分布式系统的另一个重要特性是统一。毕竟,没有人希望拥有由不同控制台控制的多个不同的系统。所有这些品质都体现在华为OceanStor Pacific新产品系列中。

新一代海量存储

OceanStor Pacific满足“六个九”(99.9999%)级别的可靠性要求,可用于创建双活类的数据中心。两个数据中心之间的距离最远为100 km,这些系统显示了2 ms的额外延迟,这使得在其基础上构建任何抗灾解决方案(包括具有Quorum Server的解决方案)成为可能。

新系列的产品展示了协议的多功能性。 OceanStor 100D已经支持块访问,对象访问和Hadoop访问。文件访问也将在不久的将来实现。如果可以通过不同的协议传送数据,则无需保留多个数据副本。

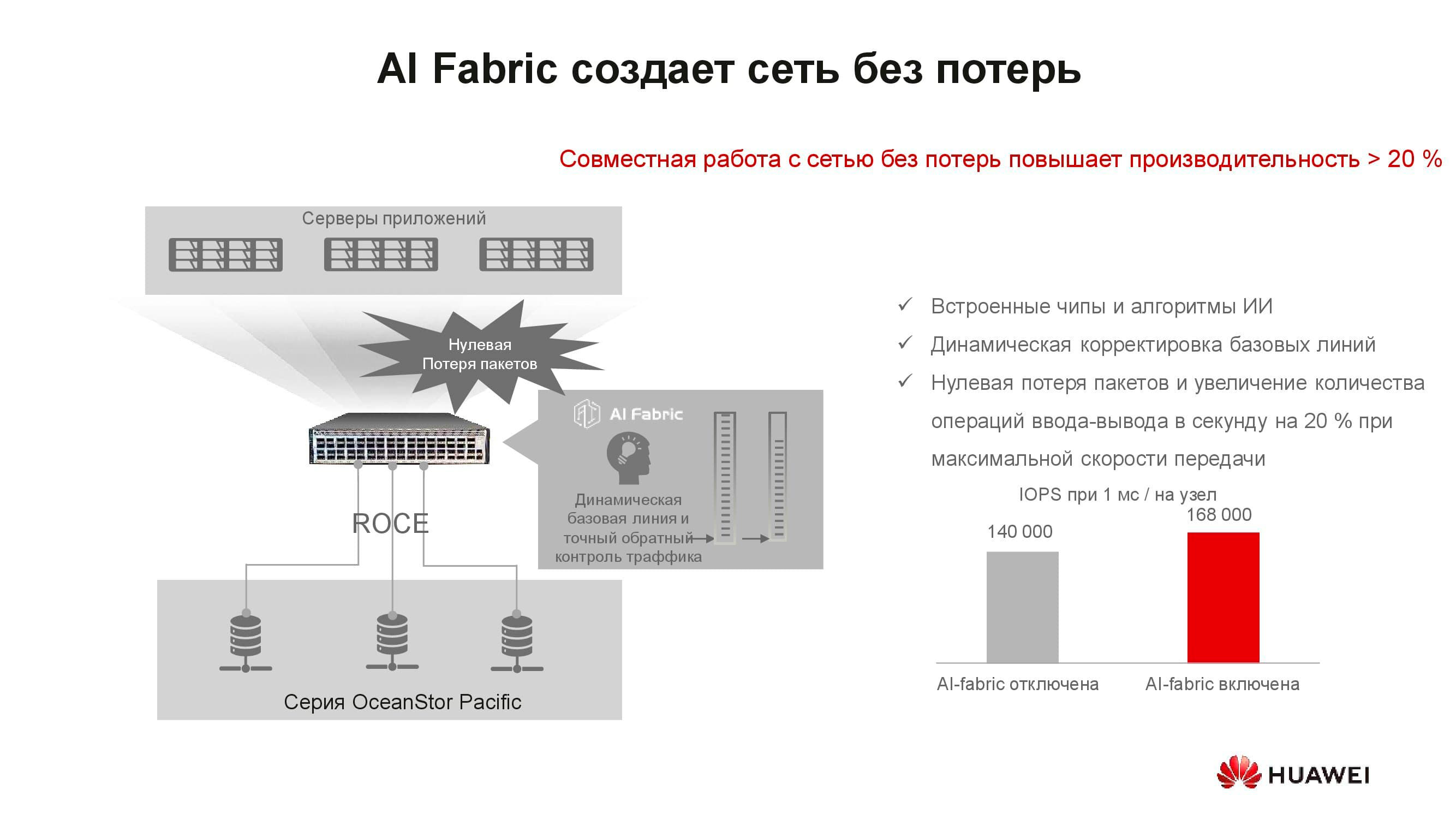

看来,“无损网络”的概念与存储有什么关系?事实是,分布式存储系统是基于支持适当算法和RoCE机制的快速网络构建的。我们的交换机支持的AI Fabric有助于进一步提高网络速度并减少延迟。 AI Fabric激活可以使存储性能提高多达20%。

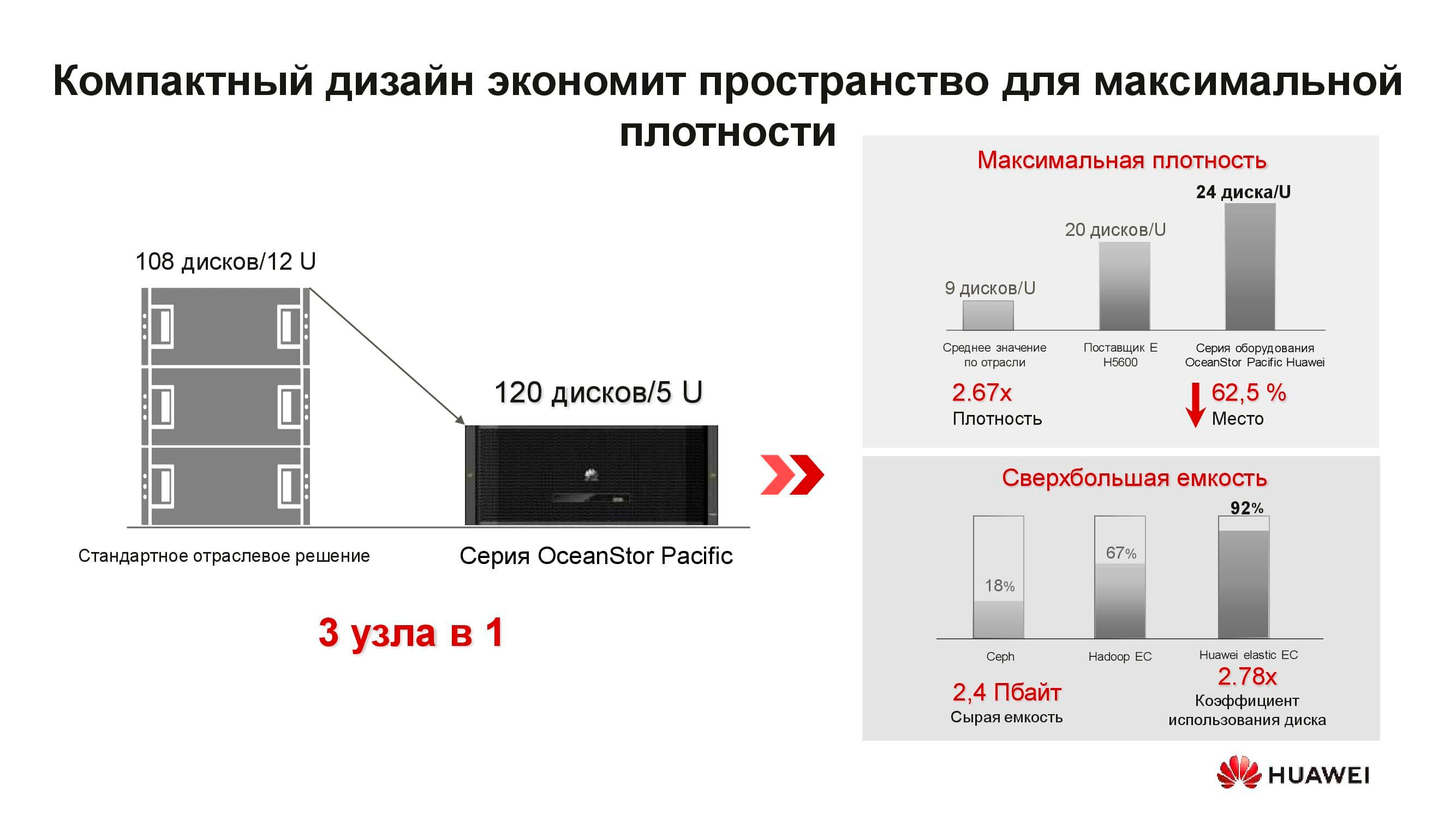

什么是新的OceanStor Pacific分布式存储节点? 5U解决方案包括120个驱动器,可以替换三个经典节点,从而节省了两倍以上的机架空间。由于拒绝存储副本,驱动器的效率显着提高(最高+ 92%)。

我们习惯于以下事实:软件定义的存储是安装在经典服务器上的特殊软件。但是现在,为了获得最佳参数,此体系结构解决方案还需要特殊的节点。它由两台基于ARM处理器的服务器组成,管理3英寸驱动器阵列。

这些服务器不适合超融合解决方案。首先,ARM的应用程序很少,其次,很难保持负载平衡。我们建议移至单独的存储:以传统服务器或机架式服务器为代表的计算集群可单独运行,但连接到也执行其直接任务的OceanStor Pacific存储节点。它证明了自己。

例如,让我们采用占用15个服务器机架的经典超融合大数据存储解决方案。通过将不同的计算服务器和OceanStor Pacific存储节点之间的工作负载分开,将它们彼此分开,所需的机架数量将减少一半!这降低了运营数据中心的成本,并降低了总拥有成本。在存储的信息量每年以30%的速度增长的世界中,这种优势并没有分散。

***

您可以在我们的网站上或直接与公司代表联系,获取有关华为解决方案和使用场景的更多信息。