由MIT-IBM Watson AI Lab开发的基于人工智能的音乐手势识别工具使用身体运动来区分各个乐器的声音。

图片由研究人员提供。

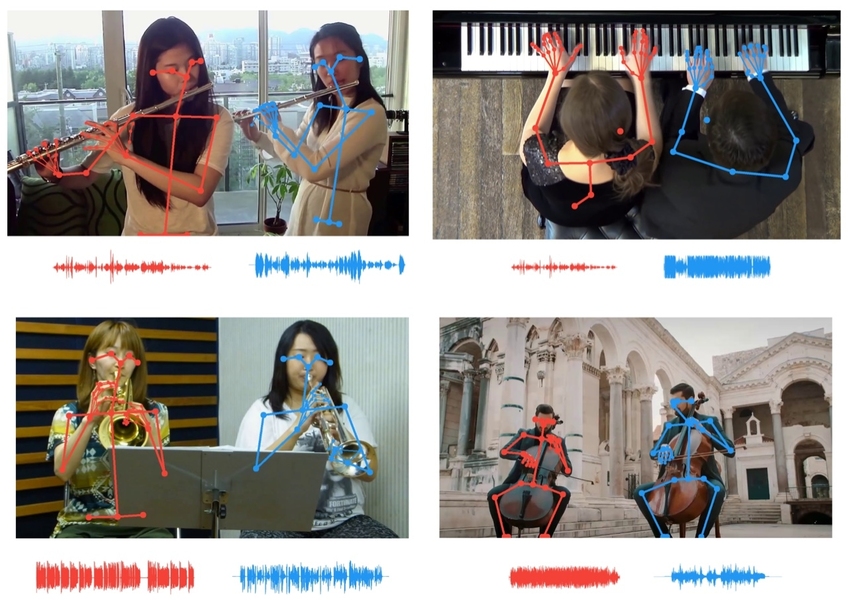

研究人员使用骨骼关键点数据将音乐家的动作与演奏的节奏关联起来,从而使听众能够隔离听起来相同的乐器。

图片由研究人员提供。

我们不仅可以用耳朵欣赏音乐,还可以用眼睛欣赏音乐,感激地欣赏钢琴演奏者的手指在琴键上飞舞,小提琴演奏者的琴弓在琴弦上摇摆。当耳朵无法分开两种乐器时,我们的眼睛会通过使每个音乐家的动作与每个部分的节奏相匹配来帮助我们。MIT-IBM Watson AI Lab开发的

新人工智能工具使用虚拟的眼睛和计算机的耳朵来分离相似的声音,以至于人们很难区分它们。与以前的迭代相比,该乐器得到了改进,方法是将使用其骨架关键点的单个音乐家的动作与单个声部的节奏对齐,从而使听众能够在多个相同的乐器之间隔离单个长笛或小提琴的声音。

该工作的可能用途包括混合声音和增加记录中的乐器音量,以减少造成人们在视频会议期间互相打扰的混乱情况。这项工作将在本月的计算机视觉模式识别会议上进行介绍。

主要作者Chuang Gang是IBM实验室的研究员,他说:“人体中的关键点提供了有力的结构信息。” “我们在这里使用它们来提高AI收听和分离声音的能力。”

在这个项目以及其他类似的项目中,研究人员使用同步的音像轨道来重新创建人们的学习方式。可以通过多种感觉模式进行学习的人工智能系统可以更快地学习,使用更少的数据,而不必在每个现实世界视图中手动添加讨厌的快捷方式。麻省理工学院教授,该研究的合著者安东尼奥·托拉尔巴(Antonio Torralba)说:“我们从所有的感官中学习。” “多传感器处理是可以执行更复杂任务的嵌入式智能和人工智能系统的先驱。”

该工具使用肢体语言来分离声音,它建立在早期的工作中,即在图像序列中使用了运动提示。它最早的化身PixelPlayer允许单击实况视频中的乐器以使其更大声或更安静。PixelPlayer更新允许您通过将每个音乐家的动作与他们各自的节奏相匹配来区分二重奏中的两个小提琴。最新版本添加了关键点数据(体育分析人员用来跟踪运动员的表现,以提取更精细的运动数据),以区分几乎相同的声音。

该作品强调了视觉提示在教学计算机中的重要性,以便它们可以更好地听见,并使用音频提示使它们具有更清晰的视觉效果。就像当前的研究使用有关音乐家动作的视觉信息来分离听起来相似的乐器的各个部分一样,先前的研究也使用声音来分离相似物体和相同物种的动物。

Torralba及其同事表明,在成对的音频视频数据上训练的深度学习模型可以学习识别自然声音,例如鸟鸣或撞击在岸上的海浪。他们还可以通过引擎的声音和朝向或远离麦克风移动的车轮的声音来确定移动车辆的地理坐标。

最新研究表明,音频跟踪工具可能会成为自动驾驶汽车的有用补充,从而在可见度不佳的情况下帮助其摄像头。“声音追踪器在夜间或恶劣天气中特别有用,有助于标记否则可能会错过的车辆,”从事运动和声音追踪研究的19岁的杭航博士说。

CVPR音乐手势研究的其他作者是麻省理工学院的Dan Huang和Joshua Tenenbaum。

就这样。要了解有关该课程的更多信息,我们邀请您通过以下链接注册开放日:

阅读更多:

我如何教我的计算机使用OpenCV和深度学习玩Doble