用C ++发明自行车或编写感知器。第三部分

让我们使用反向传播方法在C ++中实现训练多层感知器。

前言

大家好!)在开始本文基础之前,我想对前面的部分说几句话。我提出的实现是对计算机RAM tk的嘲弄。一个三维向量强奸具有大量空单元格的内存,并且为此保留了内存。因此,该方法远非最佳方法,但我希望它能帮助该领域的初学者理解最简单的神经网络的“内幕”。这次。在第一部分中描述激活函数时,我犯了一个错误-激活函数不必限制在值的范围内。这完全取决于程序员的目标。唯一的条件是必须在整个数字轴上定义函数。是两个

介绍

所以,先生,现在更接近主题。今天,我们正在实施反向传播,这是一种调整网络权重的方法。因此,让我们开始吧!

链接到前两篇文章:habr.com/ru/post/514372

一点数学

我遇到了一篇有关反向传播链接的不错的文章。

本文对所有内容进行了很好的描述,因此我将主要讨论在代码中使用这些方法。

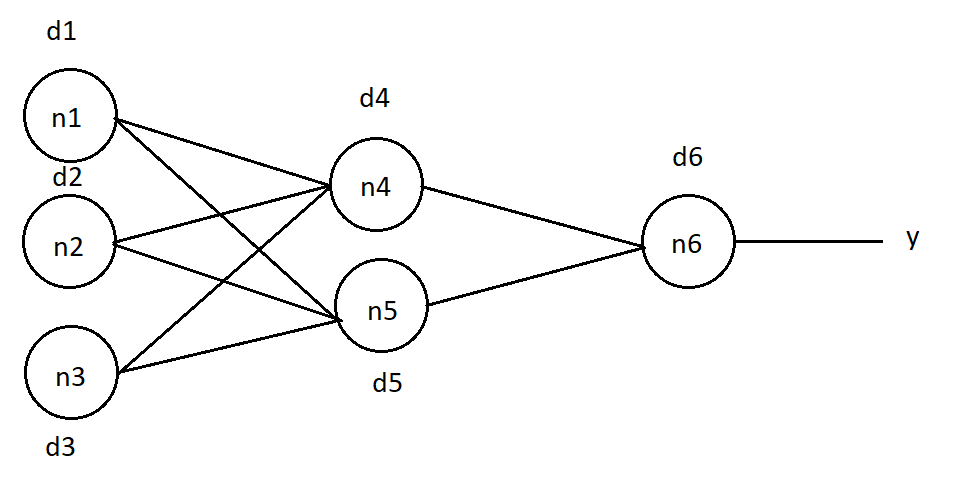

我将在这样的网络上简要说明该方法的原理:

我将尝试以这种方式正确传达学习的含义,但是,如果有的话,请在注释中更正它。因此,要训练网络,我们必须更改权重的值。此外,连接权重的变化与相应神经元给出的误差成正比。在该文章中,错误定义如下: (1), j — , , k — , , .. .

, . "O". n6 d6 = (O — y)*( f(in) )*(1 — f(in) ) (2), in —

n6, f(in) — .

(1), . n4 :

d4 = d6 * w46 *( f(in4) ) * (1 — f(in4)), w46 — n4 n6, in4 — n4.

d5 = d6 * w56 *( f(in5) ) * (1 — f(in5)), n5.

d1 = (d4 * w14 + d5 * w15) *( f(in1) ) * (1 — f(in1)), n1, , — .

n2 n3 :

d2 = (d4 * w24 + d5 * w25) *( f(in2) ) * (1 — f(in2))

d3 = (d4 * w34 + d5 * w35) *( f(in3) ) * (1 — f(in3))

, , :

Δw46 = d6 * A * f(in4), w46 — n4 n6 , f(in4) — n4, A — , — , .

Δw56 = d6 * A * f(in5), n5 n6.

:

Δw14 = d4 * A * f(in1)

Δw24 = d4 * A * f(in2)

Δw34 = d4 * A * f(in3)

Δw15 = d4 * A * f(in1)

Δw25 = d4 * A * f(in2)

Δw35 = d4 * A * f(in3)

? . .

void NeuralNet::learnBackpropagation(double* data, double* ans, double acs, double k) { //data - , ans - , k - , acs- , - :

for (uint32_t e = 0; e < k; e++) {

double* errors = new double[neuronsInLayers[numLayers - 1]]; //

// "Do_it" "Forward"

Forward(neuronsInLayers[0], data);//

getResult(neuronsInLayers[numLayers - 1], errors);//

:

for (uint16_t n = 0; n < neuronsInLayers[numLayers - 1]; n++) {

neurons[n][2][numLayers - 1] = (ans[n] - neurons[n][1][numLayers - 1]) * (neurons[n][1][numLayers - 1]) * (1 - neurons[n][1][numLayers - 1]);

}, :

for (uint8_t L = numLayers - 2; L > 0; L--) {

for (uint16_t neu = 0; neu < neuronsInLayers[L]; neu++) {

for (uint16_t lastN = 0; lastN < neuronsInLayers[L + 1]; lastN++) {

neurons[neu][2][L] += neurons[lastN][2][L + 1] * weights[neu][lastN][L] * neurons[neu][1][L] * (1 - neurons[neu][1][L]);

weights[neu][lastN][L] += neurons[neu][1][L] * neurons[lastN][2][L + 1] * acs;

}

}

}

:

void NeuralNet::learnBackpropagation(double* data, double* ans, double acs, double k) { //k - acs-

for (uint32_t e = 0; e < k; e++) {

double* errors = new double[neuronsInLayers[numLayers - 1]];

Forward(neuronsInLayers[0], data);

getResult(neuronsInLayers[numLayers - 1], errors);

for (uint16_t n = 0; n < neuronsInLayers[numLayers - 1]; n++) {

neurons[n][2][numLayers - 1] = (ans[n] - neurons[n][1][numLayers - 1]) * (neurons[n][1][numLayers - 1]) * (1 - neurons[n][1][numLayers - 1]);

}

for (uint8_t L = numLayers - 2; L > 0; L--) {

for (uint16_t neu = 0; neu < neuronsInLayers[L]; neu++) {

for (uint16_t lastN = 0; lastN < neuronsInLayers[L + 1]; lastN++) {

neurons[neu][2][L] += neurons[lastN][2][L + 1] * weights[neu][lastN][L] * neurons[neu][1][L] * (1 - neurons[neu][1][L]);

weights[neu][lastN][L] += neurons[neu][1][L] * neurons[lastN][2][L + 1] * acs;

}

}

}

}

}

. :

#include <stdio.h>

#include "neuro.h"

int main()

{

uint16_t neurons[3] = {16, 32, 10}; // , -

/* ""

*/

NeuralNet net(3, neurons);

double teach[4 * 4] = {// "" "4" , - : 4*4 = 16

1,0,1,0,

1,1,1,0,

0,0,1,0,

0,0,1,0,

};

double test[4 * 4] = {// "4", -

1,0,0,1,

1,1,1,1,

0,0,0,1,

0,0,0,1,

};

double ans[10] = {0, 0, 0, 0, 1, 0, 0, 0, 0, 0,};// , "1" , "4"

double output[10] = { 0 };//

net.Forward(4*4, teach); //

net.getResult(10, output);

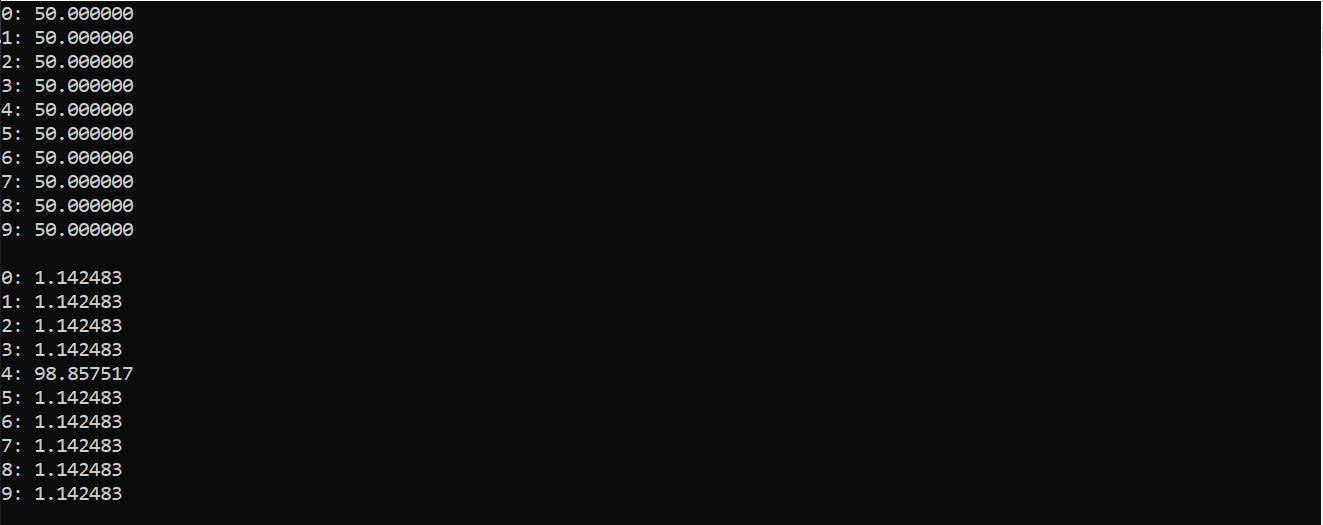

for (uint8_t i = 0; i < 10; i++) printf("%d: %f \n", i, output[i]*100); //

net.learnBackpropagation(teach, ans, 0.50, 1000); // "test", : 0.5

printf("\n");

net.Forward(4 * 4, test);//

net.getResult(10, output);

for (uint8_t i = 0; i < 10; i++) printf("%d: %f \n", i, output[i]*100);

return 0;

}

:

( ), , 0 9. . , «4»

, , - , . . . , , .

...

. , .

感谢您对本文的关注以及对先前出版物的评论。我将链接复制到库文件。

留下您的意见和建议。回头见!