虚拟现实的实时渲染带来了一系列独特的挑战,主要的挑战是需要支持真实感效果,实现高分辨率并提高刷新率。为了应对这些挑战,Facebook Reality Labs研究人员开发了DeepFocus,这是我们于2018年12月推出的渲染引擎。它使用AI在可变焦距设备中创建超逼真的图形。在今年的SIGGRAPH虚拟会议上,我们介绍了这项工作的进一步发展,为我们通往未来VR高清晰度显示器的旅程开启了新的里程碑。

我们在SIGGRAPH上发表的技术文章“实时渲染的神经超级采样”提供了一种机器学习解决方案,该解决方案将低分辨率的输入图像转换为高分辨率图像以进行实时渲染。此升采样过程使用经过现场统计训练的神经网络来恢复准确的细节,同时减少在实时应用程序中呈现这些细节的计算成本。

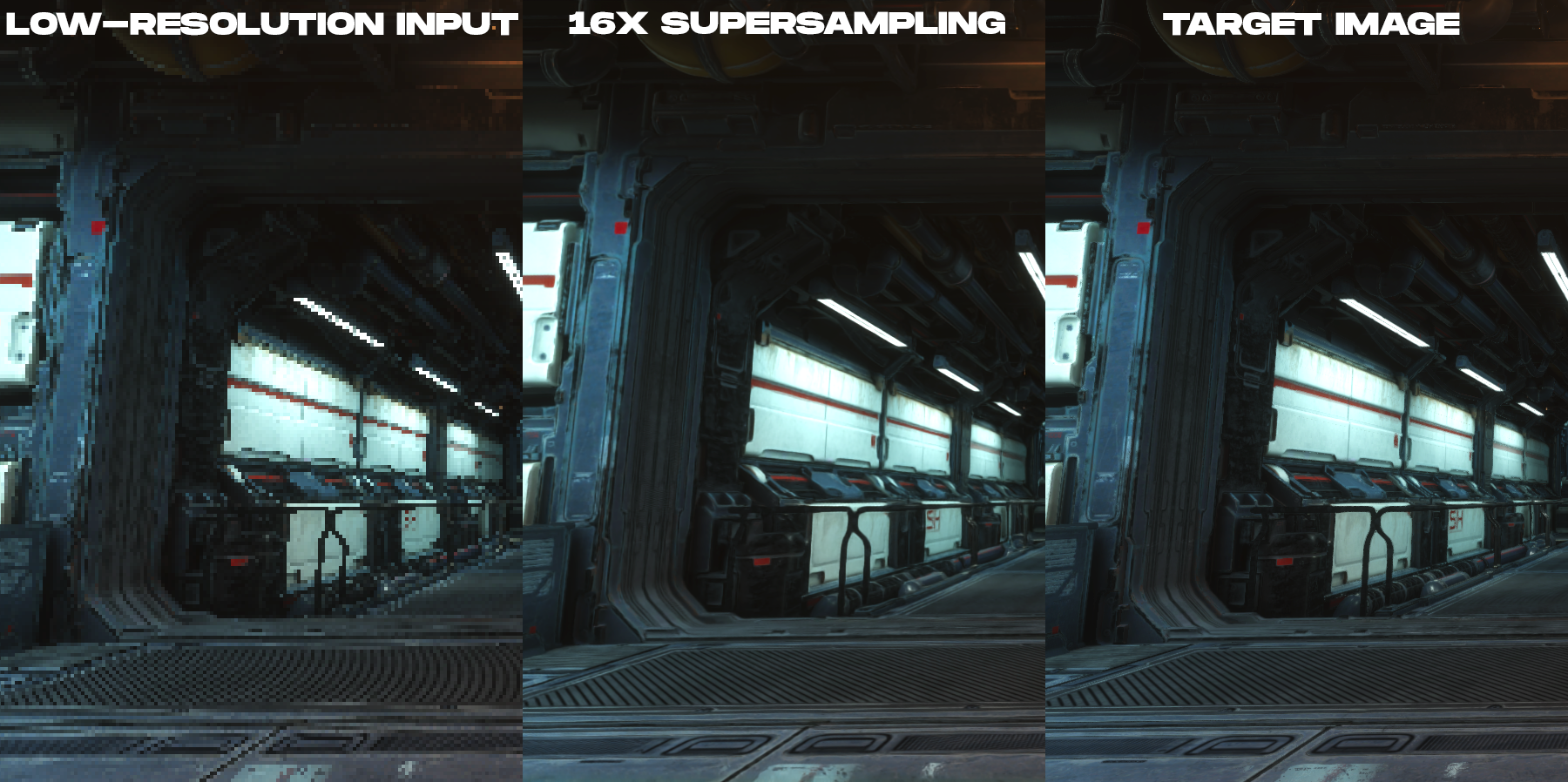

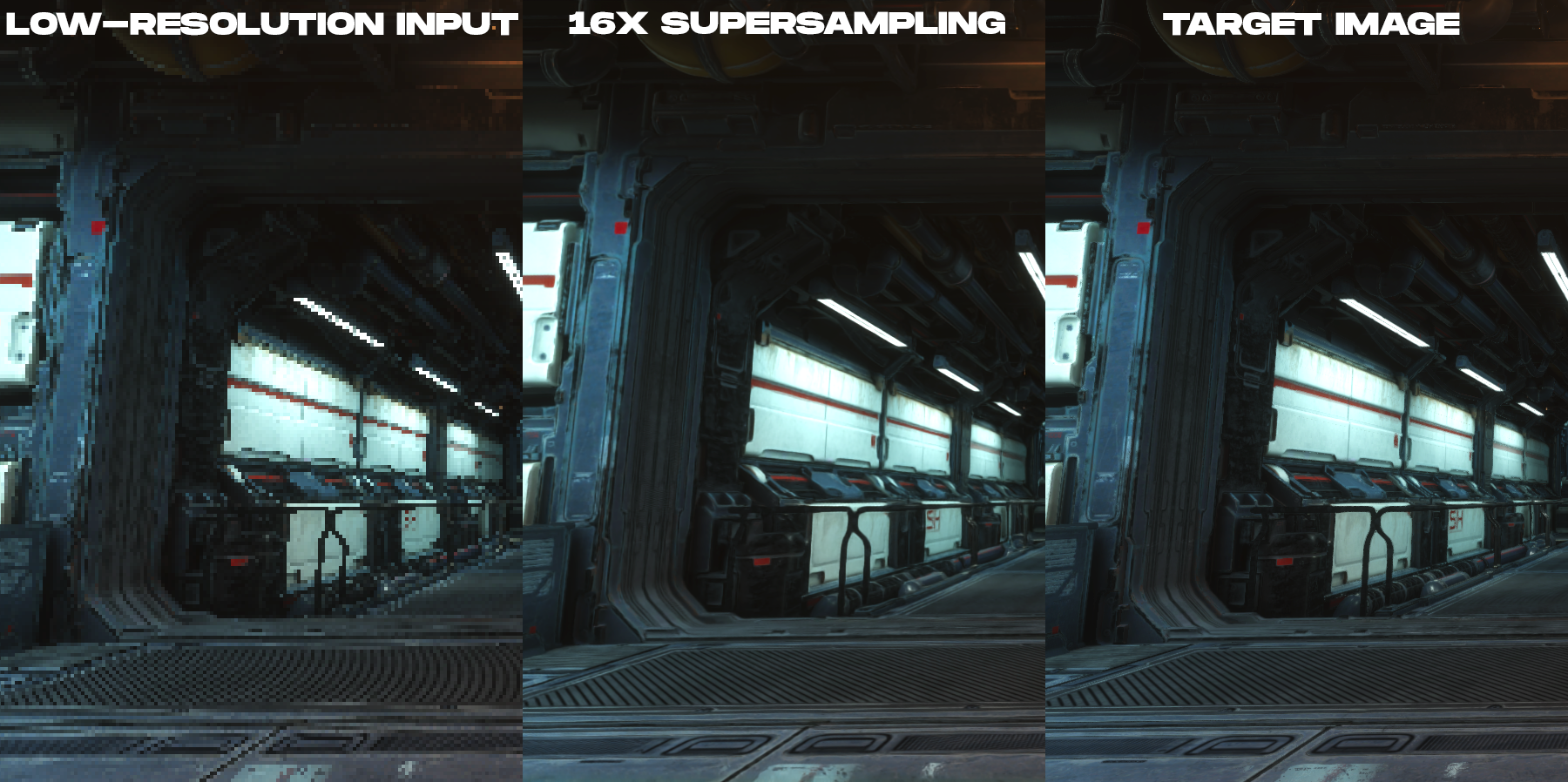

我们的解决方案是一种预训练的超级采样技术,该技术可实现内容的16倍超级采样,以高时空保真度进行渲染,大大优于以前的工作。

动画,用于比较渲染的低分辨率彩色图像和通过新的神经超级采样技术创建的16倍超级采样输出图像。

这项研究是关于什么的?

为了降低在高分辨率显示器上渲染的成本,我们的方法所拍摄的输入图像的像素比所需的输出图像少16倍。例如,如果目标显示器的分辨率为3840×2160,则网络将以960×540的输入图像大小启动otrendernnogo游戏引擎,然后在实时后处理中将其升采样至显示器的所需分辨率。

尽管已经对基于学习的摄影图像上采样进行了大量研究,但是这些工作都没有直接解决渲染内容(例如由视频游戏引擎生成的图像)的独特需求。这是因为渲染图像和摄影图像之间存在根本的成像差异。在实时渲染中,每个样本都是时间和空间上的一个点。这就是为什么渲染的内容趋向于具有严重的失真,锯齿状线条以及在本帖子的低分辨率图像示例中看到的其他采样伪像的原因。因此,渲染内容的上采样成为抗锯齿和插值的任务,而不是消除噪声和模糊的任务。计算机视觉专家对此进行了充分的研究。进入的图像高度失真并且在像素中绝对没有用于插值的信息这一事实在构造具有时间完整性的渲染内容的高度精确的重构时产生了很大的困难。

, ( , ), .

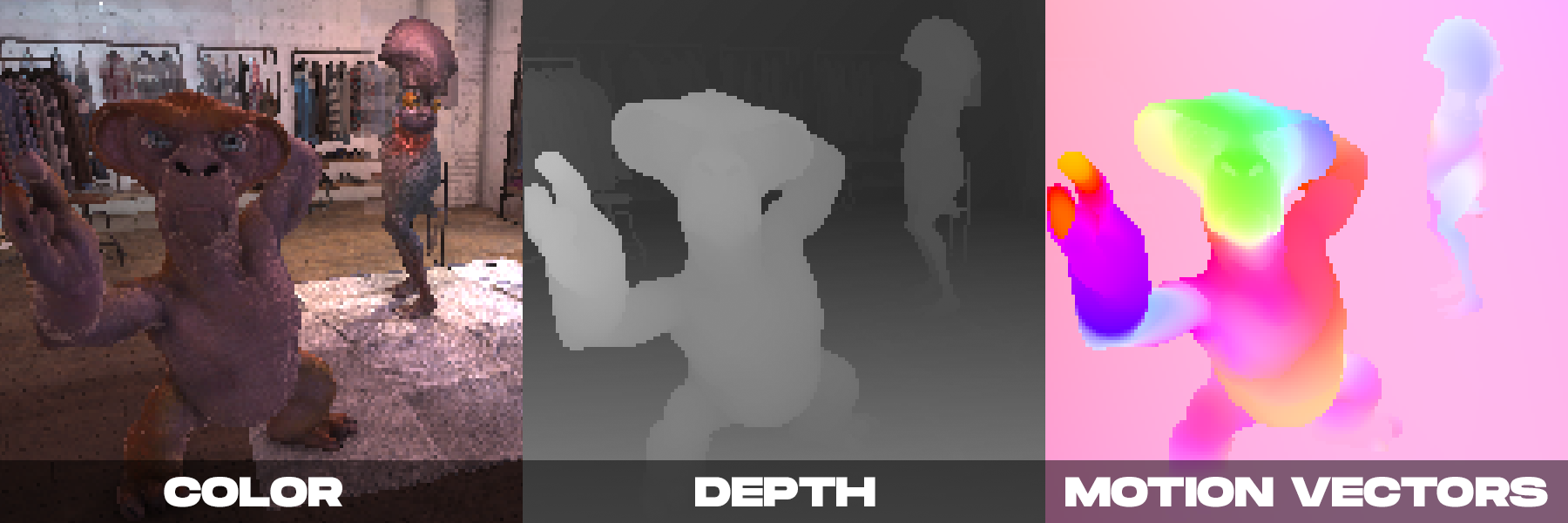

另一方面,在实时渲染时,相机可能会产生几张彩色图像。正如我们在DeepFocus中演示的那样,现代渲染引擎还提供辅助信息,例如深度值。我们注意到,通过神经超级采样,运动矢量提供的附加辅助信息尤为重要。运动矢量定义连续帧中像素之间的几何关系。换句话说,每个运动矢量指向子像素位置,在该子像素位置在一帧中可见的表面点可能已经在前一帧中。对于摄影图像,通常使用计算机视觉方法来计算这样的值,但是这种用于计算光学运动的算法容易出错。相反,渲染引擎可以直接创建密集的运动矢量,从而为神经超采样提供可靠且足够的输入,以应用于渲染内容。

基于上述观察,我们的方法将额外的辅助信息与新的时空神经网络方案相结合,该方案旨在最大化图像和视频质量,同时提供实时性能。

在做出决策时,我们的神经网络会接收以低分辨率渲染的当前帧和先前几帧的渲染属性(每帧的颜色,深度图和密集运动矢量)作为输入。网络的输出是与当前帧相对应的高分辨率彩色图像。网络使用监督学习。在训练期间,对于每个传入的低分辨率帧,将使用抗锯齿技术匹配高分辨率的参考图像,这是训练优化的目标图像。

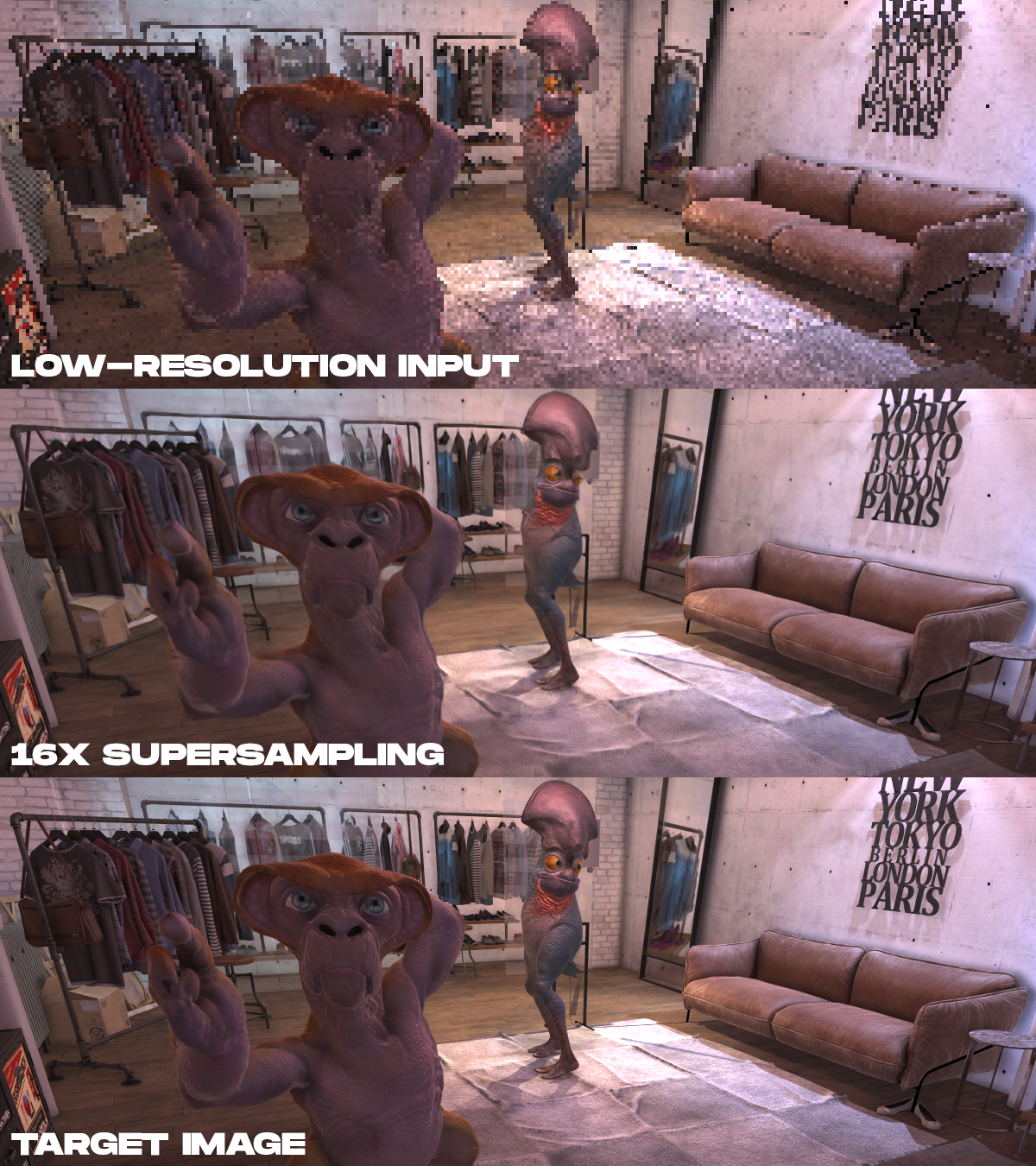

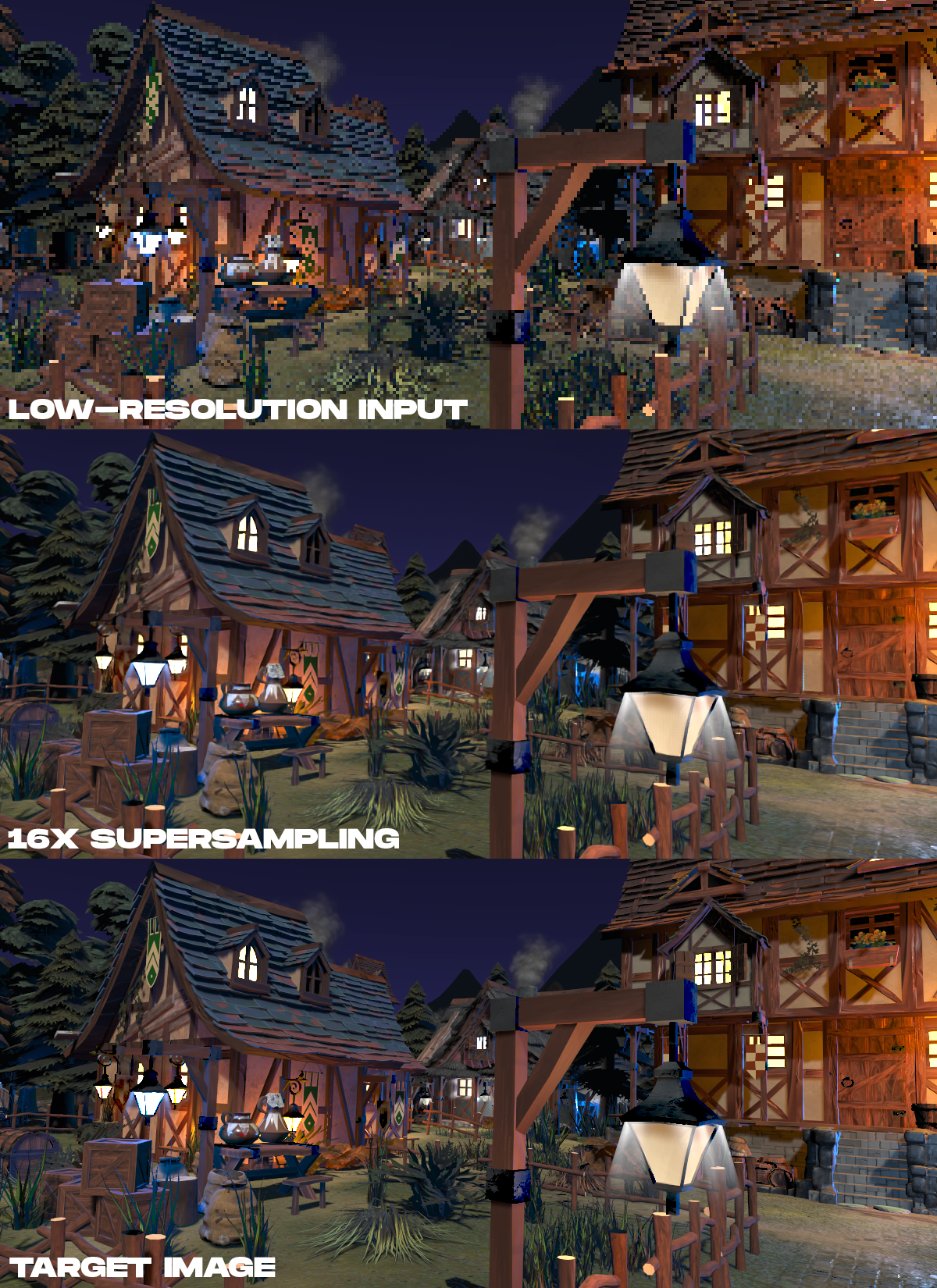

结果示例。从上至下,以低分辨率显示渲染的输入颜色数据,通过建议的方法执行16倍的超采样结果,以及以非实时方式渲染的高分辨率目标图像。

. , 16 , , , .

. , 16 , , , .

?

神经渲染在AR / VR中具有巨大的潜力。尽管这项任务很艰巨,但我们想激发其他研究人员致力于这一主题。随着AR / VR显示器制造商努力争取更高的分辨率,更高的帧速率和照片逼真度,神经超采样技术可能是从场景数据中恢复准确细节而不是直接渲染的关键方法。这项工作使我们了解到,高清VR的未来不仅在于显示器,还在于实际驱动它们所需的算法。

完整的技术文章:实时渲染的神经超级采样,Lei Xiao,Salah Nouri,Matt Chapman,Alexander Fix,Douglas Lanman,Anton Kaplanyan,ACM SIGGRAPH 2020。

也可以看看:

- “ VR开发中的渲染和优化”

- “虚拟现实中的网络物理”